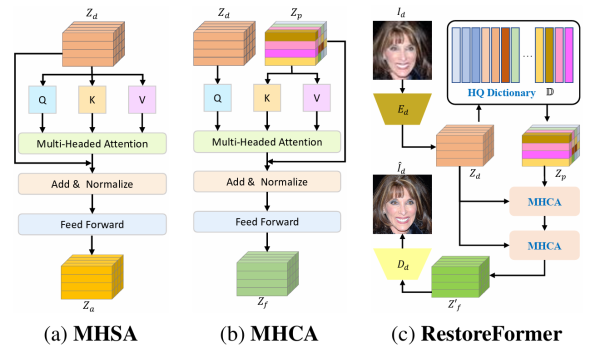

RestoreFormer收录于CVPR2022,其后续工作RestoreFormer++被收录于TPAMI2023,属于图像复原领域比较具有代表性的工作。这里需要一些transformer的前置知识,可以参见Vision Transformer.

年度归档: 2024年

ControlNet和IP-Adapter

在控制生成式模型时,ControlNet/Ip-adaptor比较有用,这边博客主要介绍ControlNet和 … 阅读更多

CVAT自动标注踩坑指北

CVAT的一些笔记和常用命令: deploy启动: docker compose -f docker-comp … 阅读更多

OpenClash BT/PT 直连的几种方式

情况一、软路由同主机部署 1. 增加规则 2. 用户ID区分 新建一个用户, id 设为 1010, 用此用户 … 阅读更多

JetBrain Pycharm ImageWatch 留档

PyCharm的ImageWatch插件最近4.0版本开始收费了,收费版本的部分功能在之前版本中都是免费的,之 … 阅读更多

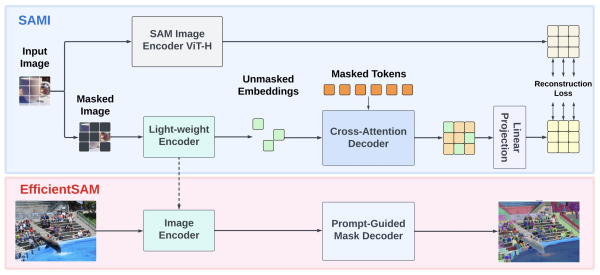

EfficientSAM论文笔记

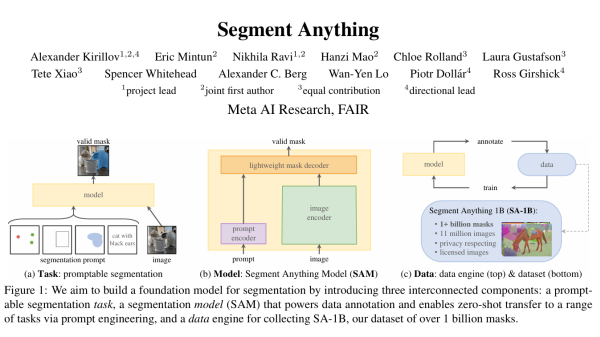

开始之前需要一些前置知识,关于SAM请移步:SAM论文笔记, 关于ViT基础请移步:Vision Transformer,关于MAE请移步知乎:MAE(Masked Autoencoders) – 知乎 (zhihu.com)。

SAM的解码器已经足够快,但是图像编码器用的ViT还是很大,于是很多工作就在SAM基础上改进性能,进行轻量化,其中有一些比较出色的工作 比如 MobileSAM 、 FastSAM 和 EfficientSAM 等,已经将SAM推到了相当轻量。这篇博客主要是EfficientSAM的论文笔记。

软路由(七)OpenClash安装和配置

OpenClash是在OpenWrt上构建基于Clash内核运行的网络功能插件,插件本身相当复杂,使用有一定门槛,这篇博客 带小白做最基本的安装和配置。

自编码器AE、VAE、dVAE、VQ-VAE、VQ-VAE2

在多模态、生成模型中会用到几种类型的自编码器,通常具有Encoder、Decoder的结构。

DALL-E论文笔记

DALL-E是OpenAI的多模态与训练模型,有120亿参数,在2.5亿图像文本对上寻来呢完成,主要用于文生图后续有DALL-E2和DALL-E3,其中DALL-E和DALL-E2是可以找到源代码和权重的,后面的DALL-E3是闭源的。学习原理的话我们从DALL-E入手。

从GPT开始,zero-shot的想法开始成为自然语言处理的主流,而视觉领域能否zero-shot呢(训练一个大模型,后续使用不需要微调)?CLIP和DALL-E告诉我们视觉也可以zero-shot,所以文章的Tile是Zero-Shot Image Generation,DALL-E的名字灵感来自于著名画家Salvador Dali和墨西哥的墙Wall-E。