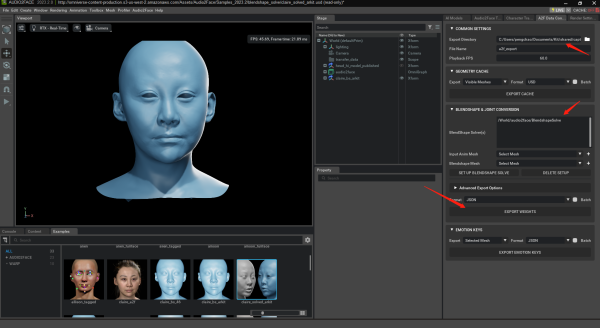

omniverse和blender结合有两种方式,一种是blender中的模型导入到omniverse中产生形态键动画,然后再导回blender,这种方式可以直接参见nvidia的视频guide,另一种方式是omniverse直接产生动画,在blender中利用插件完成绑定,我们这里介绍后面这种。

这篇博客主要介绍利用Omniverse驱动人体模型和面部表情映射的大致基本流程,主要介绍两套工具之间的桥梁,不会具体到每个参数,如果需要系统学习,可以单独找omniverse或者blender的课程,它们会介绍的更详细。开始之前,需要有blender操作基础,以及对Riggfy,ARP(Auto Rig Pro)和Faceit 动画绑定插件有一些基本了解。